先日、「Google Search Console Team」から下記メールが届きました。

https://nichiyogogo.com/ でのアクセス許可エラーの増加をスマートフォン用 Googlebot が検出しました

メールに記載されている内容を見ると…

…なるほど。それは困るということで、サーチコンソールで”アクセスできないURL”を調べることに。

目次

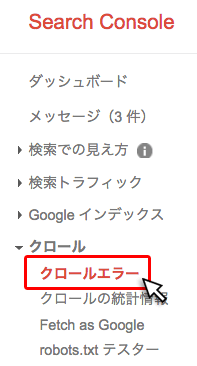

サーチコンソールでアクセス許可エラーのURLを確認

1.「サーチコンソール」にアクセスし、サイドメニューから「クロール > クロールエラー」をクリック。

↓

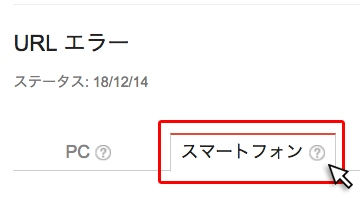

2.スマートフォンタブをクリック

↓

3.ブロックされているURLを確認

ブロックされているURLを確認すると、共通点が。

それは、「wp-login.php?」ページで「403エラー」が発生しているということ。

これをわかりやすく言い換えると…

「Wordpress管理画面のログインページ」にGoogleクローラーがアクセスしたものの、IDとパスワードを求められ、先の画面へ進むことを断念。

そのため、クローラーが「これらのページにアクセスを拒否されました!!」と伝えてくれてる訳です。

管理画面へのログインは、ブログ運営者であるぼくしかできないのは”当たり前っちゃ当たり前の話”なんですが、クローラーにそんなことわかる訳ありません。

なので、こちらから「このページはクロール(巡回)しなくていいよ!」とクローラーへ知らせる必要があります。

robots.txtを作成し、「wp-login.php?」ページをクロールの対象外に設定する

1.「robots.txt」を「テキストエディタ or メモ帳」で作成します。

| テキストエディタ(無料) | サクラエディタ(Win) Sublime Text(Mac) |

|---|

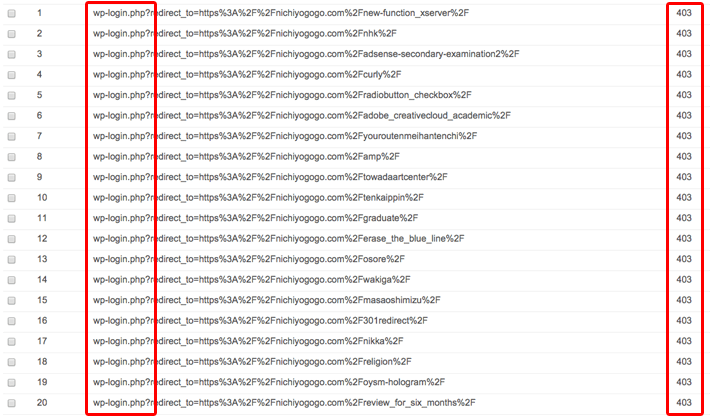

↓「robots.txt」に記述する内容は以下の通り。

|

1 2 3 4 5 6 |

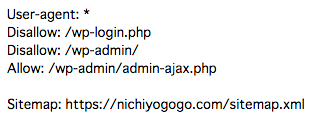

User-agent: * Disallow: /wp-login.php Disallow: /wp-admin/ Allow: /wp-admin/admin-ajax.php Sitemap: [サイトURL]/sitemap.xml |

5行記述しましたが、初期設定で既に「Disallow: /wp-login.php」以外の記述がされているため、実質記述するのは1行です。

実質記述するのはこれだけ

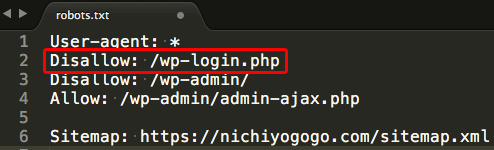

ちなみにデフォ(初期)で設定されている「robots.txt」の記述内容は、サーチコンソール上で確認できます。

robots.txt の初期設定

それぞれの意味は以下の通り。

| User-agent | クローラの指定。「*」と記述することで、すべてのクローラーが対象になります。 |

|---|---|

| Disallow | 指定したページのクロール(巡回)を拒否。 |

| Allow | Disallowで指定した中で、特定のページのみクロール(巡回)を許可。 |

| Sitemap | サイトマップの設置場所。 |

↓

2.「robots.txt」というファイル名で保存。

↓

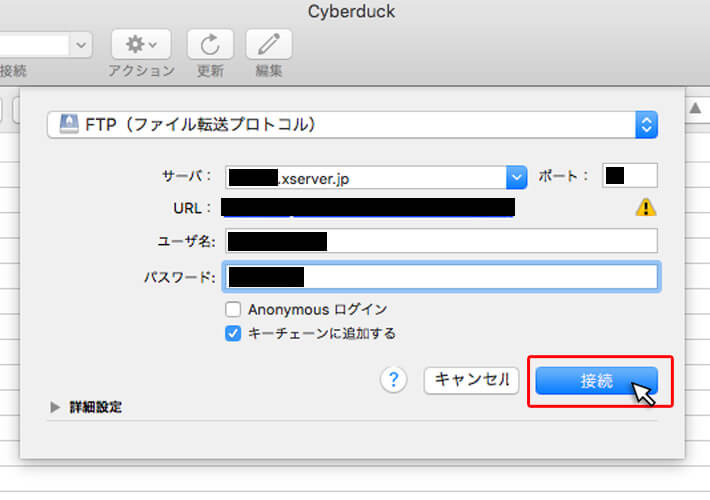

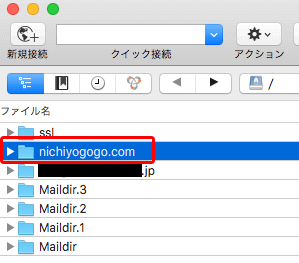

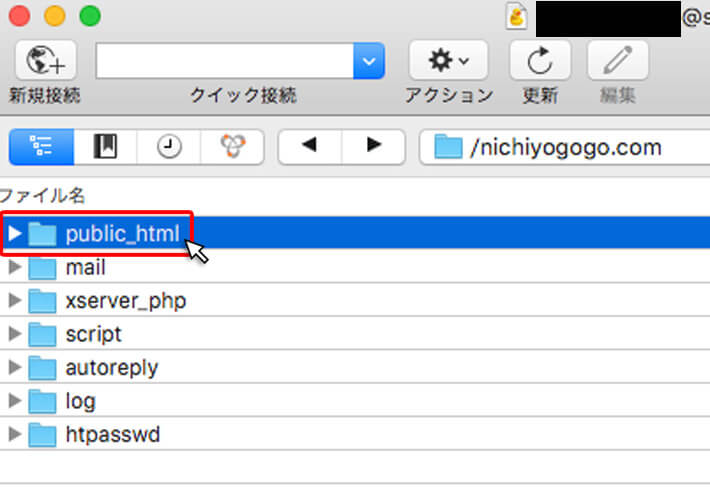

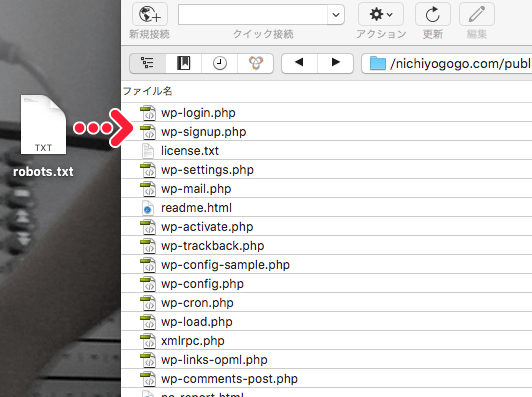

3.「ドメイン名/public_html」フォルダに「robots.txt」をアップロード。

FTPソフトを利用してアップロードします。

| FTPソフト(無料) | FFFTP(Win) Cyberduck(Mac) |

|---|

以下、サイバーダックの場合。

これで「Wordpress管理画面のログインページ」がクロール(巡回)の対象外になりました。

Search Consoleで設定内容が反映されているか確認

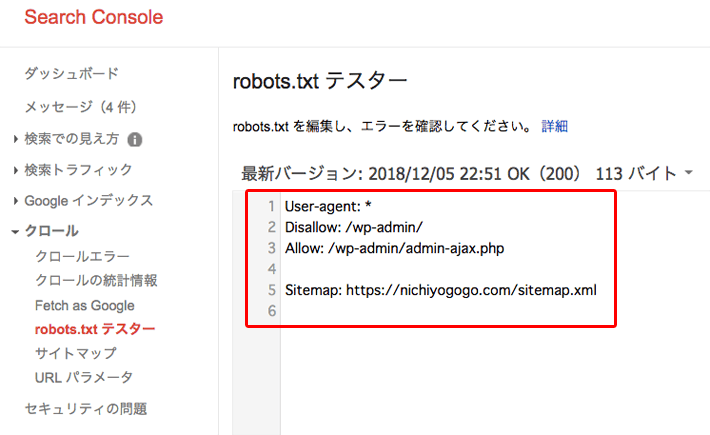

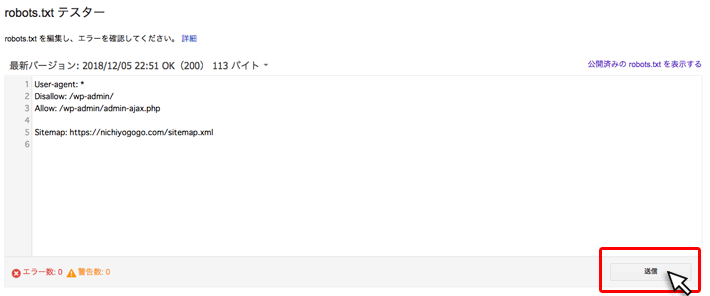

1.「サーチコンソール」にアクセスし、サイドメニューから「クロール > robots.txt テスター」をクリック。

↓

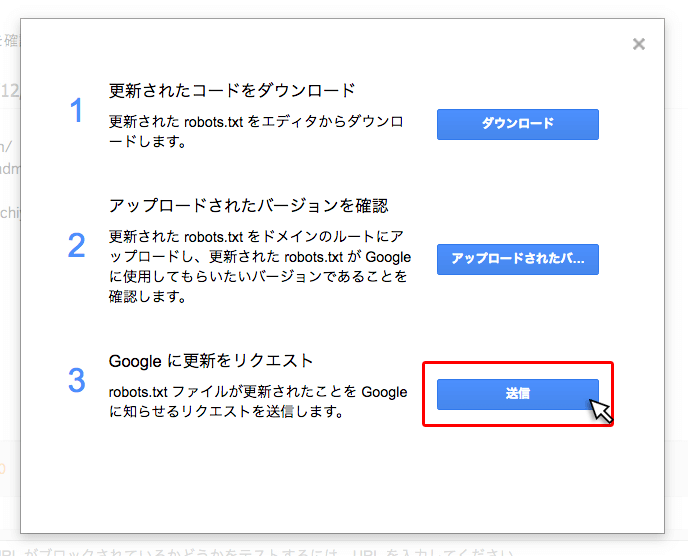

2.送信 をクリック。

↓

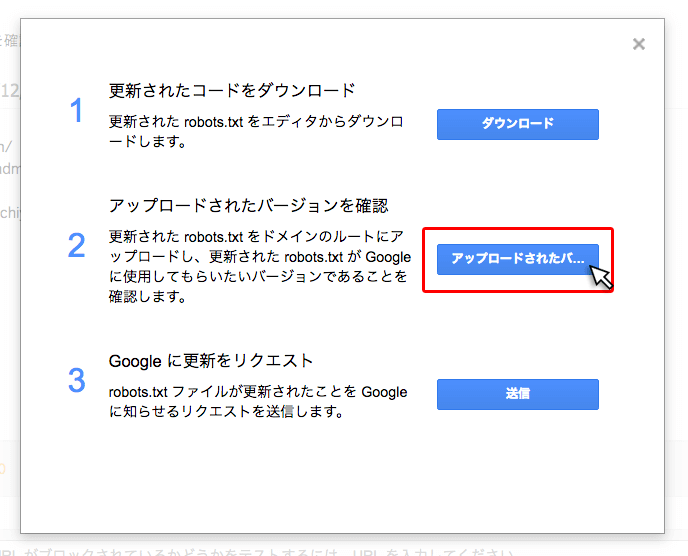

3.アップロードされたバージョンを確認 をクリック。

↓

4.「robots.txt」に記述した内容が反映されているか確認

↓

5. Googleに更新をリクエストの送信をクリック。

これで「robots.txt」の内容が更新されました。

・・・

正直なぜこのタイミングで「wp-login.php?」ページで「403エラー」が発生したのかは不明です。

コチラ側で最近行った作業は、WordPressテーマ「SANGO」とWordPress自体のアップデート位。

でかいっちゃでかい変更点ですが、いろんな情報を見ていると、サーバー側のメンテナンスが原因っぽいんですよね。。

まぁ、「wp-login.php?」ページ、つまり「Wordpress管理画面のログインページ」に今後クローラーが巡回することは無くなったので、この件は一件落着です。

そんな感じで。終わりッ!!

(2025/05/18 02:22:05時点 Amazon調べ-詳細)